突然ですが、大好きなキャラクターのイラストがあって、「この子に踊らせたい!でも絵柄や顔つきは変えたくない…」なんて思ったことありませんか?

「いや、無茶でしょ?絵を動かしたら崩れるんじゃ…」と思いますよね?でも実は、今のAIツールならそれが意外とできてしまうんです。

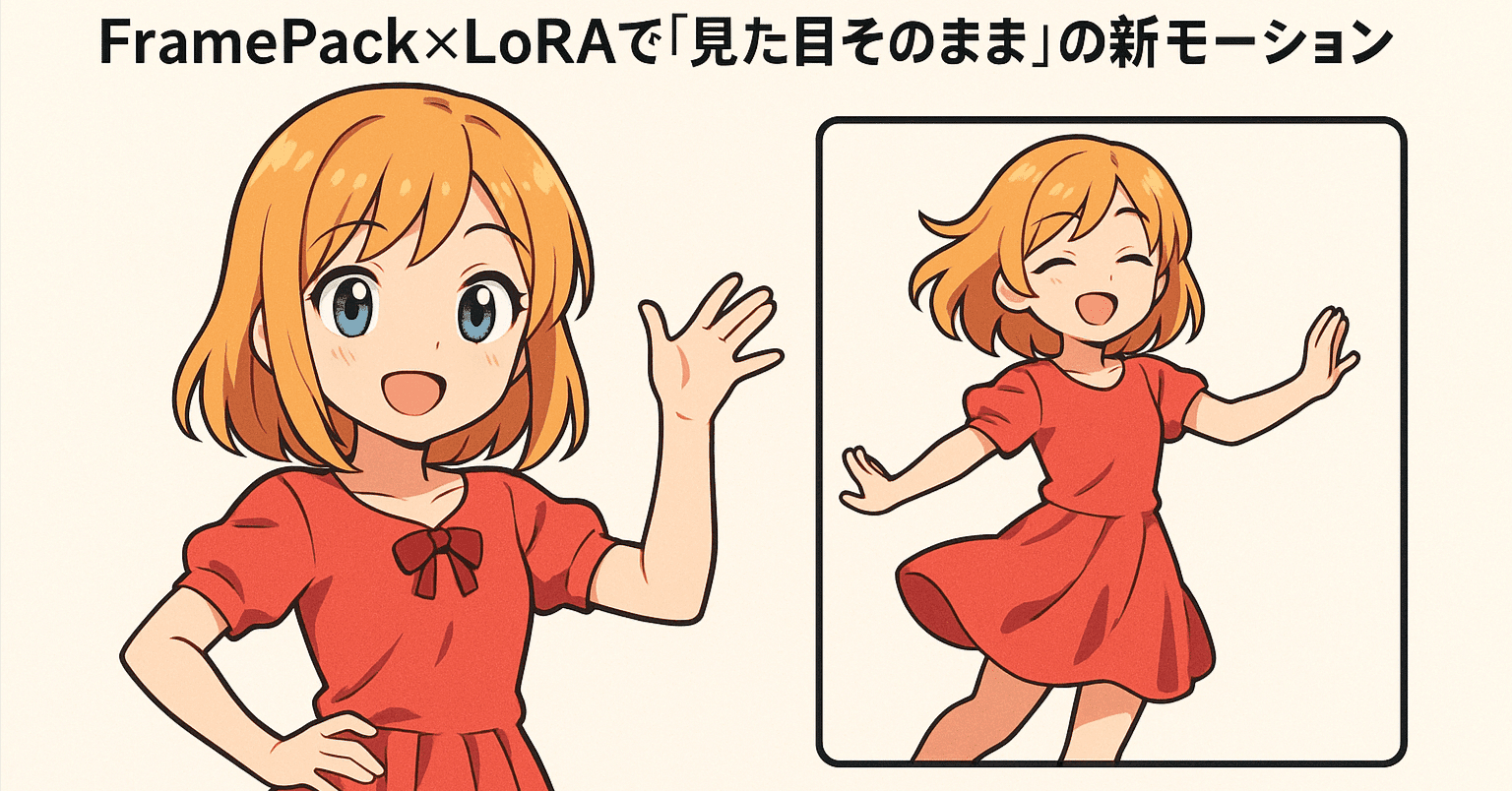

その名もFramePack。そしてそこにLoRA(ローラ)を加えると、「デザインはそのままで新しい動きを覚えさせる」という面白い魔法がかかります。

この記事では、FramePackがいかに初期フレーム(最初の1枚)を大事に扱い、キャラクターの見た目を最後まで忠実に保ってくれるか、そしてLoRAを使ってどんな動きを教え込めるのかを紹介します。例えばダンスやウォーキングだけじゃなく、表情の変化やカメラワークまで…!

「これってどういうこと?」と思いません?さあ、この続きを読めば、きっと「動かしたいイラスト」が浮かんでくるはず。早速その秘密を探っていきましょう。

FramePackの基本:最初のフレームの魅力を守り抜く

FramePackは動画生成に使われるAIモデルの一種ですが、大きな特徴は「初期フレーム(最初の一枚)を軸に、そこから未来のフレームを予測する」点です。

どういうことかというと、普通の動画生成モデルは連続するフレームを同じくらいの重みで扱うことが多いのですが、FramePackは最初のフレームをめちゃくちゃ大事にして、その情報を次のフレームにしっかり伝える仕組みを持っています。具体的には「初期フレームや直近のフレームは詳細に、古いフレームはざっくり」という風に使い分けることで、

キャラクターの見た目の変形(いわゆるドリフト)を防ぐようにしています。

これ、ピンと来ない人向けにたとえると、最初の1枚を「本家の設計図」だと思ってください。FramePackはその設計図を常に参照しながら、次のコマを生成するので、時間が進んでも服の色や顔の輪郭、画風などがブレにくいんです。

「でも動かすなら、いつか崩れるでしょう?」と疑問に思いません? そこをFramePackはうまく押さえているわけです。つまり、「どう動かすか」は任せるけど、「誰が動いているのか」は最初の絵をいちいち確認して守ってくれる。ここが一番のミソなんです。

LoRAで動きを追加しても、スタイルは崩れない?

さらにここで登場するのが

LoRA(ローラ)です。LoRAは「大きなモデルに新しい知識を後付けする小さな学習モジュール」とイメージしてください。

FramePack自体は「キャラの見た目を保持しつつ動画を生成する」力を持っていますが、具体的な動き(ダンスやジェスチャー、カメラワークなど)をイチから大量に学習させるのは大変。そこでLoRAに、その動きだけを学習させれば、「元のモデル+LoRA」で手軽に新しいモーションを追加できるわけです。

LoRAに覚えさせたい動きは実にさまざま。例えば:

-

全身アクション

ダンス、ウォーキング、ランニング、マーシャルアーツの構えなど。「Boxing LoRA」でパンチを繰り出すボクサーの動きを覚えさせる例もあります。

-

ジェスチャー・小さな仕草

キスを投げる、手を振る、拍手する、うなずく…といった動き。たとえば“BlowAKiss” LoRAを使うと、キャラが口元に手を持っていってキスを投げる仕草を自然にしてくれるんです。

-

表情変化やアイドルモーション

髪が揺れたり、瞬きしたり、笑顔になったり…。大きく動かないけど、ほんの少し表情が動くだけでガラッと印象が変わりますよね。

-

カメラワークや演出

カメラをグルッと回り込ませたい、ズームイン・ズームアウトしたい、70年代カンフー映画みたいに素早くパンさせたい…といった撮影技術も、LoRAで学習できます。

どの動きを入れるにしても、FramePackは「初期フレームのビジュアルを死守」してくれるので、

LoRAが動きを教え込んでもキャラのデザインまでは書き換えられないんですね。結果、「見た目そのまま」「動きはLoRAが教えた通り」に、いいとこ取りの動画が生成できるわけです。

モーションLoRAをどうやって作る?必要なデータと手順

「でもLoRAを作るにはまた大変な訓練がいるのでは?」と思うかもしれません。もちろん何も知らずに作るのは難しいけれど、実はコミュニティで使えるツールやノウハウがだいぶ整備されています。ここではざっくり流れを説明しましょう。

● 学習に使うデータを選ぶ

LoRAに教えたい動きがあるなら、そのモーションを映した動画クリップやフレーム連番画像をいくつか用意します。例えば「くるりと回転するダンス」LoRAなら、ダンサーがくるっと回っている動画を短く切り出し、何本か集めます。

「1本の動画だけでもいい?」という声がありそうですが、それだと学習した動きがピンポイントすぎて汎用性があまり出ません。やっぱり

複数の動画で、多少バリエーションを持たせたほうが「この動きの概念」をしっかり覚えてくれます。

また、キャラの見た目が現実なのかアニメ調なのかで動画のテイストを合わせたいところですが、必須ではありません。実写動画を使って動きだけを学ばせ、最終的にアニメキャラに適用する例もあります。

キャプション(テキストラベル)もあると学習がスムーズです。動画の内容を簡潔に書いたテキストを付与しておけば、「このフレーズを見たらこの動き」と紐づけられます。ただしスタイルやキャラの固有名詞はあまり入れず、「(例)キャラがダンスで回転している」程度がベスト。あくまで「動き」を学ばせたいので、余計な要素を混ぜないようにしましょう。

● FramePack向けLoRA学習の環境設定

FramePack(TencentのHunyuanVideoベース)にLoRAを組み込むには、対応したトレーニングスクリプトを使います。

よく使われるのが、

Musubi Tuner(Kohya SSの改造版)やdiffusers/diffusion-pipeのFramePack対応ブランチなど。流れとしては次のような感じです:

-

ベースモデルを読み込む

HunyuanVideoのベースモデル+FramePack用のカスタムTransformerを組み合わせたものを準備します。

-

データセットの設定

動画や連番画像、キャプションを指定。FramePackが処理できる解像度にリサイズするなど、細かい設定もします。

-

学習パラメータを調整

LoRAのrank(16や32など)、学習率(1e-3あたりが目安)などを設定。動画フレームを扱うのでメモリ消費が大きく、一度に大量のバッチは難しいため、小さめバッチで進めることが多いです。

-

数エポック回してチェック

何百ステップか学習してはテストし、動きが身に付いているかを確認する。あまり学習しすぎると特定のフレームを丸暗記して変なノイズが出たりするので、適度なところでやめるのがコツ。

一部のスクリプトでは、フレームをランダムにシャッフルしたり、時系列をずらしたりするテクニックが使われることもあります。これは「動画の順番をただ丸暗記しないようにする」工夫ですね。とにかく、

“動きを学習させたい”という目的で動画を与えることがポイントです。

● 学習後のLoRAファイルをゲット

無事に学習が終われば、.safetensorsなどの形式でLoRAが出力されます。例えば「回転モーションLoRA」ならrotate.safetensorsみたいなファイル名。

これをFramePackで推論(動画生成)するときに読み込めば、新しい回転動作をキャラに与えられる、というわけです。

FramePack×LoRAを使って推論:実際にどう動かす?

学習済みのLoRAを手に入れたら、いよいよ推論フェーズ。

ComfyUIか

FramePack Studioが主なフロントエンドとして人気です。

設定の手順は若干違いますが、やることはほぼ同じ:

「FramePackモデルを読み込む→LoRAを選択またはロードする→初期フレームとプロンプトを用意して動画生成」

という流れになります。

● ComfyUIでの手順

ComfyUIは強力なノードベースUIで、そこにFramePack用ノードと「Select LoRA」ノードを差し込むイメージ。

LoRAのノードではfuse_loraをtrueにしてモデルと合体させる設定が推奨されています。こうすることで生成過程でLoRAがしっかり効きやすくなるそうです。

複数のLoRAをチェーンすることも可能。「ダンスLoRA」に加えて「表情変化LoRA」も重ねる…なんてこともできますが、互いの動きが干渉することもあるので注意。強すぎるLoRA同士だと片方が消えてしまったり、動きが破綻したりしがちです。

プロンプト(テキスト入力)には「どんな動きをしてほしいか」を自然文で書きます。例えば「カメラが右にパンして別のキャラを映す」LoRAなら、

「[キャラクターの説明]。カメラは右にパンしてシーンを映し出す。」

といった感じで、学習時に使ったフレーズに近い言葉を入れると効果的。

そして初期フレームに「このキャラの絵」を設定。これだけで、「同じ見た目のキャラクターが、カメラパンのモーションを再現する動画」が出てくるわけです。

オプションとしては、

終わりのフレーム(最終形を指定する画像)を与えるかどうかも選べます。連続で大きく動かしたい場合はあえて終わりを決めない方がダイナミックな結果になりやすいです。その代わり終盤での姿勢が少しブレることもあるので、そこは好み。

「LoRAの強度(重み)」の調整もポイント。1.0を基準に、もっと激しく動かしたいならやや上げたり、キャラの顔が崩れるときは下げたり…という感じで微調整するといいです。

● FramePack Studioでの手順

FramePack StudioはGradioベースのGUI。LoRAファイルをloras/フォルダに入れておくと、起動後の画面でLoRAを選択可能。

同時に複数のLoRAを読み込み、スライダーでそれぞれの強度を調節できます。やり方はComfyUIほど自由度は高くないですが、その分シンプルで扱いやすいです。

さらに、FramePack Studioには「タイムスタンプ付きプロンプト」の機能もあるので、動画の途中でプロンプトを変えることも可能。3秒後に歩き始める、とか一旦停止してから再び走り出す、みたいなシナリオを組めるわけです。複雑なシーンを作りたい人には魅力的な機能でしょう。

● うまくいくためのコツ

-

初期フレームとプロンプトを一致させる

もし初期フレームが「赤い服の女の子」なのにプロンプトで「鎧を着た男がパンチを繰り出す」なんて書いたら、FramePackとLoRAがどちらに従うべきか混乱します。見た目を保ちたいなら、初期画像と矛盾しないプロンプトを心がけましょう。

-

シードやステップ数を試す

Diffusionは乱数に左右されるので、同じ設定でも違う動画が出たりします。気に入る動きが出るまで何回か再生成したり、ステップ数(推論回数)を増やしたりして調整するのも手。

-

初期ポーズも大事

座ってる絵からいきなりジャンプするモーションは、ちょっと不自然になるかもしれません。ある程度、動きやすいポーズを最初に用意しておくとスムーズに動きが出ます。

-

トリガーワードをチェック

LoRAによっては「spin」という単語を入れないと回転モーションが出ない…みたいに、学習時のキャプション次第で動きが引き出しにくくなる場合があります。作者の説明や自分の学習時の設定をしっかり見直しましょう。

-

LoRA強度の微調整

「LoRAの効果が強すぎるとキャラが歪む、でも弱めると動きが少ない」…このジレンマは常にあるので、うまくバランスを探るとGood。

-

前方推論だけor双方向推論

FramePackには「1→2→3…」と順に生成する前方モードと、「最初と最後のフレームを固定して中間を埋める」双方向モードがあります。前方モードの方が動きに自由度がある反面、フレーム後半でブレることも。エンディングを決めたいなら後者が便利、といった使い分けです。

結論:新しいモーション、でもいつものあの子

FramePackが最初のフレームを大事に扱うおかげで、イラストのキャラクターを動画にしても「誰かが変身しちゃった…」みたいな崩れが起きにくい。

そこにLoRAで新しい動きを加えられるのが今回のポイントです。ガッツリ踊らせるもよし、ちょっと手を振るだけでもよし、カメラを動かして映画っぽく演出するもよし。

“見た目そのまま、新しいモーション”が実現できるんです。

もちろん、この技術にも制限はあります。1回の生成で作れる動画の長さに限界があったり、複雑な長編アニメのように完全な自然さを出すにはまだ研究中だったり。

でも、少ないデータで好きな動きを教え込めて、しかもキャラのデザインを保持できる…これはかなり革命的ですよね。

たとえばゲームのキャラクターのイラストを、LoRAで「走り」「ジャンプ」「攻撃」をそれぞれ覚えさせれば、まるで公式アニメーションみたいな動画を生成できるかもしれません。しかも全部「同じ絵柄」で統一できるのはすごい。

最後にまとめると:

-

FramePackは初期フレームからキャラクターの見た目をがっちり守り、動画の各フレームを生成

-

LoRAを使えば、ダンス・パンチ・表情変化など自由自在に「新しい動き」を学習させられる

- それらを組み合わせると、「見た目はそのまま、動きだけは変化自在」という動画が作れる

ちょっと面白そうじゃないですか?

もし手元にお気に入りのイラストがあれば、「このキャラを踊らせるとどうなる?」と想像してみるとワクワクしてきません?

実際にやってみたい人は、FramePackとLoRAの導入ガイドや学習用スクリプトを探してみてください。きっと、静止画が生き生きと動き出す瞬間に驚くはずです。

参考文献・情報源

- Zhang, Lvmin et al. FramePack: Packing Input Frame Contexts in Next-Frame Prediction Models for Video Generation (2025) – arXiv preprint.

- Rickard Edén (neph1), “FramePack LoRA Experiment” – HuggingFace Community Blog, April 19, 2025.

- ComfyUIでFramePackにLoRAを使うやり方を紹介します (Using LoRA with FramePack in ComfyUI), Ichi’s AI Blog, May 11, 2025.

- Yunomix, 髪揺れLoRAを作ってFramePackでAI動画生成したい (Training a Hair-Sway LoRA for FramePack), Note.com, April 2025.

- HunyuanVideo with LoRA: Best AI Video Generator, MimicPC Blog, April 27, 2025.

- Colinurbs,

FramePack Studio – GitHub README (2025).

- Toriniku, Musubi TunerでFramePackのLoRA学習 (Training FramePack LoRA with Musubi Tuner), Note.com, April 22, 2025.

- Ichi’s AI Blog, FramePackをComfyUIで使って2枚の画像から動画生成するやり方 (FramePack with start and end frames in ComfyUI), April 30, 2025.